Un gros NAS.

Re: Un gros NAS.

je vois qu'ils sont "multimode fiber", c'est donc de la fibre.pourquoi pas pour être dans le cas de figure numéro 4.

Économiquement ça reste plus élevé que la solution 3 que je vais très sûrement adopter.

Merci à vous pour la réflexion sur le réseau, je pense que c'est statué.

J'attends la livraison, a/c du 20/03 pour les cartes PCIe/M2.

Je ne vous avais pas donné le détail mais si 1 NAS est en M2.SATA, l'autre (secours) est en bon vieux SATA AHCI, je viens de lui remplacer ses disques dépareillés par une série de Seagate Barracuda 2 To en (1+1) mirror (1+1), 3.6 To d'espace, 2.25 occupés pour l'instant ça va.

Ils débitent plus en lecture et écriture que ce que le réseau gigabit ne peut délivrer donc ça va.

Si un jour je viens à manquer d'espace je passe en 1+1+1+1 RaidZ en rajoutant un spare (6 ports Sata dispos).

Un jour il faudra que je script un truc qui parse le résultat de zfs status et qui m'alerte si STATE est différent de ONLINE, comme les NAS se réveillent et se synchronisent seuls et de nuit, je ne suis pas là pour voir s'ils sont en bonne santé.

Économiquement ça reste plus élevé que la solution 3 que je vais très sûrement adopter.

Merci à vous pour la réflexion sur le réseau, je pense que c'est statué.

J'attends la livraison, a/c du 20/03 pour les cartes PCIe/M2.

Je ne vous avais pas donné le détail mais si 1 NAS est en M2.SATA, l'autre (secours) est en bon vieux SATA AHCI, je viens de lui remplacer ses disques dépareillés par une série de Seagate Barracuda 2 To en (1+1) mirror (1+1), 3.6 To d'espace, 2.25 occupés pour l'instant ça va.

Ils débitent plus en lecture et écriture que ce que le réseau gigabit ne peut délivrer donc ça va.

Si un jour je viens à manquer d'espace je passe en 1+1+1+1 RaidZ en rajoutant un spare (6 ports Sata dispos).

Un jour il faudra que je script un truc qui parse le résultat de zfs status et qui m'alerte si STATE est différent de ONLINE, comme les NAS se réveillent et se synchronisent seuls et de nuit, je ne suis pas là pour voir s'ils sont en bonne santé.

Re: Un gros NAS.

Yep j'ai des fibres en plus des sfp+ vers rj45.

Mes pc sont soit en 10g soit 5 soit 2.5. le reste en giga.

Mes pc sont soit en 10g soit 5 soit 2.5. le reste en giga.

Re: Un gros NAS.

ben moi comme d'hab j'ai du retard technologique

Re: Un gros NAS.

Si t'as besoin de sfp simple j'en ai tout ce quil faut.

Et de la fibre, en multi en tout cas (je garde la mono, j'essaie de faire du 100% de mono la maison).

MP, ca te coûtera les fdp.

Et de la fibre, en multi en tout cas (je garde la mono, j'essaie de faire du 100% de mono la maison).

MP, ca te coûtera les fdp.

Re: Un gros NAS.

j'y ai pensé ! (cela ne servira a rien mais voila)

si c'est écrit SFP-10G-T ou ou SFP-10G-SR ce sont mes SFP vers RJ45 10g le reste c'est de la fibre

si c'est écrit SFP-10G-T ou ou SFP-10G-SR ce sont mes SFP vers RJ45 10g le reste c'est de la fibre

Re: Un gros NAS.

un grand merci pour cette proposition.

Mais comme je le disais je ne pense pas revoir la partie réseau.

@biour, pas mal, les températures sont celle obtenue avec une ventilation ? ça reste correct, faut pas que le ventilo crame ctout

bon, si tout va bien dans 1 semaine j'aurai les 3 ex de https://nasts-srv1.myftp.org/smp/station_zfs/4xm2.jpg

je pourrai alors passer mon weekend sur la gestion de ZFS.

Vu la météo actuelle, ça me va, de toute façon tout ce qui était vivant dans ma serre potagère a cramé dans la nuit de jeudi à vendredi à cause du gel, je suis bon pour tout refaire mais j'attendrai que le beau temps soit stable.

Re: Un gros NAS.

@Ryu Yep

voici une photo, c'est fixé sous un bureau donc j'ai sécurisé a l’arache (le ventilo serait plus bas ce serait mieux)

voici une photo, c'est fixé sous un bureau donc j'ai sécurisé a l’arache (le ventilo serait plus bas ce serait mieux)

Re: Un gros NAS.

osef, c'est fonctionnel

Re: Un gros NAS.

Tiens, en parlant de température,

je découvre qu'un disque dur, JOURNALISE ses températures !

Ceci consécutivement au fait que le démon smart rapporte n'importe quoi dans syslog et m'ait alerté

je découvre qu'un disque dur, JOURNALISE ses températures !

Ceci consécutivement au fait que le démon smart rapporte n'importe quoi dans syslog et m'ait alerté

il est pourtant précisé "celcius" mais quand on lit directement la valeur on trouve cecismartd[1841]: Device: /dev/sdd [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 102 to 101

Code : Tout sélectionner

sudo smartctl -x /dev/sddje trouve ça énorme, en tout cas je ne savais pas.smartctl 7.4 2023-08-01 r5530 [x86_64-linux-6.8.0-55-generic] (local build)

Copyright (C) 2002-23, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Model Family: Seagate Barracuda LP

Device Model: ST32000542AS

Serial Number: 6XW17XV7

LU WWN Device Id: 5 000c50 01f4284d6

Firmware Version: CC34

User Capacity: 2 000 398 934 016 bytes [2,00 TB]

Sector Size: 512 bytes logical/physical

Rotation Rate: 5900 rpm

Device is: In smartctl database 7.3/5528

ATA Version is: ATA8-ACS T13/1699-D revision 4

SATA Version is: SATA 2.6, 3.0 Gb/s

Local Time is: Sun Mar 16 09:18:13 2025 CET

[16 Ko d'informations diverses et variées plus tard]

SCT Status Version: 3

SCT Version (vendor specific): 522 (0x020a)

Device State: Active (0)

Current Temperature: 49 Celsius

Power Cycle Min/Max Temperature: 44/49 Celsius

Lifetime Min/Max Temperature: 3/50 Celsius

Under/Over Temperature Limit Count: 0/0

SCT Temperature History Version: 2

Temperature Sampling Period: 10 minutes

Temperature Logging Interval: 59 minutes

Min/Max recommended Temperature: 14/55 Celsius

Min/Max Temperature Limit: 10/60 Celsius

Temperature History Size (Index): 128 (24)

Index Estimated Time Temperature Celsius

25 2025-03-11 04:05 40 *********************

26 2025-03-11 05:04 41 **********************

27 2025-03-11 06:03 39 ********************

28 2025-03-11 07:02 38 *******************

29 2025-03-11 08:01 38 *******************

30 2025-03-11 09:00 ? -

31 2025-03-11 09:59 17 -

32 2025-03-11 10:58 17 -

33 2025-03-11 11:57 36 *****************

34 2025-03-11 12:56 40 *********************

35 2025-03-11 13:55 39 ********************

36 2025-03-11 14:54 35 ****************

37 2025-03-11 15:53 33 **************

38 2025-03-11 16:52 ? -

39 2025-03-11 17:51 10 -

40 2025-03-11 18:50 10 -

41 2025-03-11 19:49 28 *********

42 2025-03-11 20:48 32 *************

43 2025-03-11 21:47 32 *************

44 2025-03-11 22:46 33 **************

... ..( 2 skipped). .. **************

47 2025-03-12 01:43 33 **************

48 2025-03-12 02:42 34 ***************

49 2025-03-12 03:41 35 ****************

50 2025-03-12 04:40 38 *******************

51 2025-03-12 05:39 41 **********************

52 2025-03-12 06:38 40 *********************

53 2025-03-12 07:37 38 *******************

54 2025-03-12 08:36 37 ******************

55 2025-03-12 09:35 37 ******************

56 2025-03-12 10:34 37 ******************

57 2025-03-12 11:33 36 *****************

58 2025-03-12 12:32 36 *****************

59 2025-03-12 13:31 36 *****************

60 2025-03-12 14:30 35 ****************

61 2025-03-12 15:29 35 ****************

62 2025-03-12 16:28 35 ****************

63 2025-03-12 17:27 36 *****************

64 2025-03-12 18:26 35 ****************

... ..( 2 skipped). .. ****************

67 2025-03-12 21:23 35 ****************

68 2025-03-12 22:22 36 *****************

69 2025-03-12 23:21 ? -

70 2025-03-13 00:20 15 -

71 2025-03-13 01:19 15 -

72 2025-03-13 02:18 37 ******************

73 2025-03-13 03:17 41 **********************

74 2025-03-13 04:16 ? -

75 2025-03-13 05:15 33 **************

76 2025-03-13 06:14 33 **************

77 2025-03-13 07:13 41 **********************

78 2025-03-13 08:12 43 ************************

79 2025-03-13 09:11 44 *************************

80 2025-03-13 10:10 43 ************************

81 2025-03-13 11:09 39 ********************

82 2025-03-13 12:08 37 ******************

83 2025-03-13 13:07 37 ******************

84 2025-03-13 14:06 36 *****************

85 2025-03-13 15:05 36 *****************

86 2025-03-13 16:04 ? -

87 2025-03-13 17:03 15 -

88 2025-03-13 18:02 ? -

89 2025-03-13 19:01 16 -

90 2025-03-13 20:00 16 -

91 2025-03-13 20:59 34 ***************

92 2025-03-13 21:58 38 *******************

93 2025-03-13 22:57 ? -

94 2025-03-13 23:56 17 -

95 2025-03-14 00:55 17 -

96 2025-03-14 01:54 36 *****************

97 2025-03-14 02:53 41 **********************

98 2025-03-14 03:52 42 ***********************

99 2025-03-14 04:51 42 ***********************

100 2025-03-14 05:50 42 ***********************

101 2025-03-14 06:49 43 ************************

102 2025-03-14 07:48 45 **************************

103 2025-03-14 08:47 42 ***********************

104 2025-03-14 09:46 45 **************************

105 2025-03-14 10:45 46 ***************************

106 2025-03-14 11:44 46 ***************************

107 2025-03-14 12:43 46 ***************************

108 2025-03-14 13:42 45 **************************

109 2025-03-14 14:41 ? -

110 2025-03-14 15:40 13 -

111 2025-03-14 16:39 ? -

112 2025-03-14 17:38 18 -

113 2025-03-14 18:37 18 -

114 2025-03-14 19:36 36 *****************

115 2025-03-14 20:35 42 ***********************

116 2025-03-14 21:34 44 *************************

117 2025-03-14 22:33 41 **********************

118 2025-03-14 23:32 40 *********************

119 2025-03-15 00:31 ? -

120 2025-03-15 01:30 14 -

121 2025-03-15 02:29 14 -

122 2025-03-15 03:28 38 *******************

123 2025-03-15 04:27 46 ***************************

124 2025-03-15 05:26 47 ****************************

125 2025-03-15 06:25 45 **************************

126 2025-03-15 07:24 44 *************************

127 2025-03-15 08:23 42 ***********************

0 2025-03-15 09:22 41 **********************

1 2025-03-15 10:21 42 ***********************

2 2025-03-15 11:20 43 ************************

3 2025-03-15 12:19 42 ***********************

4 2025-03-15 13:18 40 *********************

5 2025-03-15 14:17 ? -

6 2025-03-15 15:16 12 -

7 2025-03-15 16:15 12 -

8 2025-03-15 17:14 37 ******************

9 2025-03-15 18:13 45 **************************

10 2025-03-15 19:12 46 ***************************

11 2025-03-15 20:11 46 ***************************

12 2025-03-15 21:10 43 ************************

13 2025-03-15 22:09 42 ***********************

14 2025-03-15 23:08 43 ************************

15 2025-03-16 00:07 41 **********************

16 2025-03-16 01:06 40 *********************

17 2025-03-16 02:05 40 *********************

18 2025-03-16 03:04 39 ********************

19 2025-03-16 04:03 39 ********************

20 2025-03-16 05:02 41 **********************

21 2025-03-16 06:01 ? -

22 2025-03-16 07:00 44 *************************

23 2025-03-16 07:59 44 *************************

24 2025-03-16 08:58 48 *****************************

Re: Un gros NAS.

voila ceux que j'utilisais avant de passer en full 10g

(defois en promo)

https://fr.aliexpress.com/item/1005006821857211.html

https://fr.aliexpress.com/item/1005006866459336.html

https://fr.aliexpress.com/item/1005006822096018.html

(defois en promo)

https://fr.aliexpress.com/item/1005006821857211.html

https://fr.aliexpress.com/item/1005006866459336.html

https://fr.aliexpress.com/item/1005006822096018.html

Re: Un gros NAS.

3 ex. de https://nasts-srv1.myftp.org/smp/station_zfs/4xm2.jpg reçus ce jour

tests demain si j'ai le temps.

tests demain si j'ai le temps.

Re: Un gros NAS.

Pour réaliser les tests, j'ai à ma disposition des M2.Sata 256 Go SK Hynix, Toshiba, Micron/Crucial, Western Digital, Sandisk ainsi que 3 PC différents.

Les M2.Sata ont été effacés et testés via des docks USB3 Nvme/M2.Sata.

Ceux qui avaient un débit suspect ou des petits défauts ont été écartés.

Je garde un pool de 20 exemplaire de chaque.

Premier constat, seuls les M2 Micron et Sandisk sont reconnus

Je réalise une première carte avec 2 Micron et 2 Sandisk -> 4x M2 visibles ok.

j'assemble ensuite un set de 4*3 Micron

Premier problème, ça bloque au boot

https://nasts-srv1.myftp.org/smp/nas/20 ... 134240.mp4

serait-ce un souci avec un M2 ? Non

https://nasts-srv1.myftp.org/smp/nas/20 ... 134434.mp4

les soucis vont s'enchainer, les PC ont du mal à amorcer, quand enfin ça fonctionne le temps d'amorçage est infernal (OS sur NVme carte mère pourtant)

Il est quasi impossible d'avoir deux amorçages successifs possible, des fois les cartes figent des fois les M2 sont mal reconnus

https://nasts-srv1.myftp.org/smp/nas/20 ... 134711.mp4

L'OS le plus conciliant est Ubuntu, j'arrive à amorcer et à voir les 12 M2, cependant très rapidement, et après de multiples essais sur les 3 PC, 1 carte disparait systématiquement. Je prends la décision de l'enlever du test afin d'avancer.

j'amorce donc sur 2 PC différents

1 avec la carte suspecte, l'autre avec les 2 cartes, sous Win10

temps de chargement horrible, formatage des M2 sous Windows : une blague

Une fois formatés, ils sont impossibles à tester, explorer est en sablier infini et Crystal Disk Mark se fait seppuku.

je retourne sous Ubuntu avec la station qui embarque 2 cartes.

Même là j'ai des anomalies, comme des créations/suppressions de partitions qui figent.

des fois les medias disparaissent

Quand j'obtiens enfin un ensemble stable je me lance dans la création d'un pool Raidz1

Il faut plus de 40 secondes pour obtenir le résultat de "zpool status"

sans rien faire d'autre, je vois qu'une carte clignote, initialisation ?

mais non

je coupe le PC, je change le M2 "fautif" je détruis le pool, je le crée à nouveau

même chose

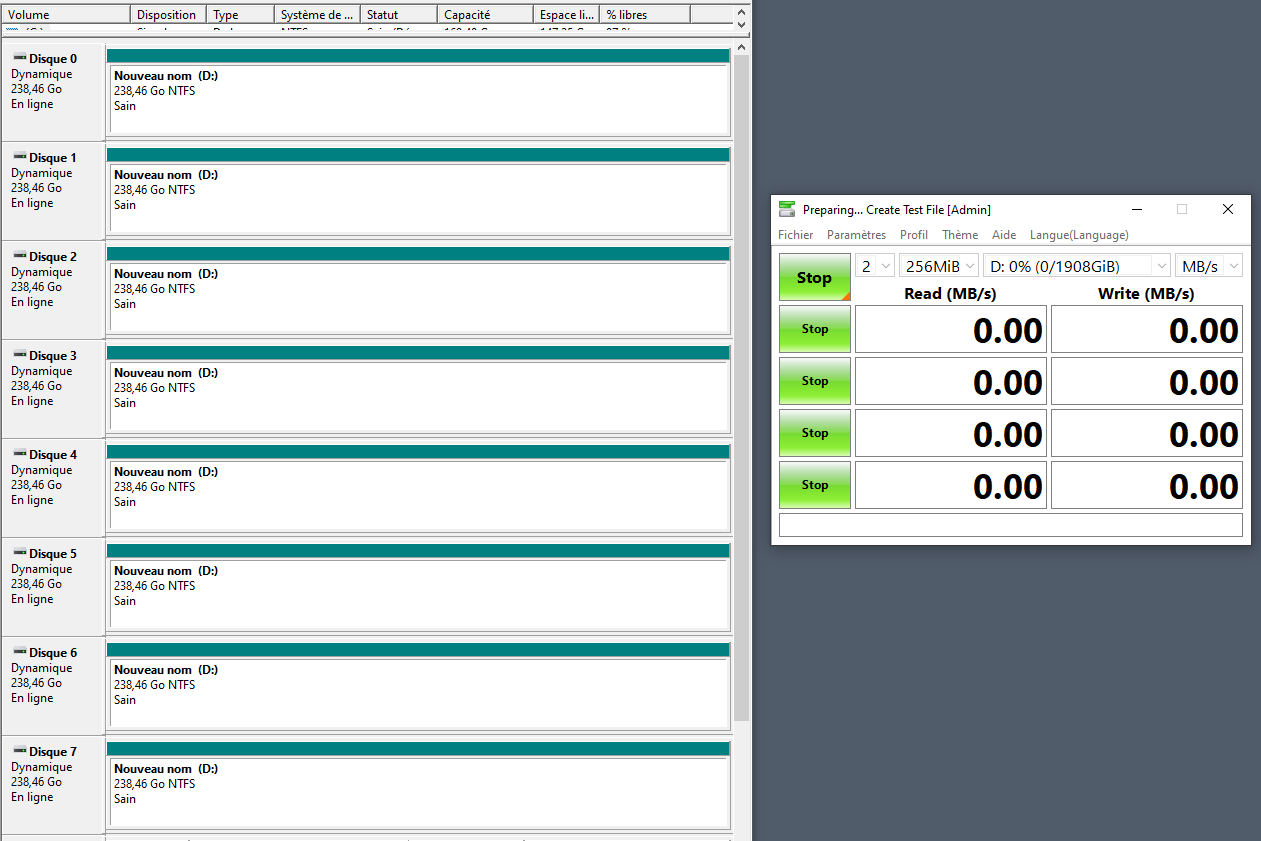

je lance un test, le débit est ... je vous laisse apprécier

je coupe le PC, je change le M2, je détruis le pool je le refais, ça laggue et

clairement le 4è slot de la carte 2 est défectueux

---

Je n'avais pas d'a priori sur ces produits Made in RPC/china, après tout ils font tout, mais là c'est bien de la merde.

Direction Ebay pour faire un litige

Re: Un gros NAS.

c'est le problème de ce genre de carte :/

t'as des versions asus/hyperx pour avoir 4 ports mais le tarif est clairement pas le même

t'as testé avec un SSD/carte pour voir ?

t'as des versions asus/hyperx pour avoir 4 ports mais le tarif est clairement pas le même

t'as testé avec un SSD/carte pour voir ?

Re: Un gros NAS.

Oui je sais, comme je le disais en préambule, je possède déjà une carte 5 ports, mais ce n'est pas le même prix (80 balles) et de plus c'est une 16x (bon, un peu overkill)

Je n'ai pas testé 1 ssd par carte non, je n'en vois pas l’intérêt. Tu as une idée ?

Je n'ai pas testé 1 ssd par carte non, je n'en vois pas l’intérêt. Tu as une idée ?

Re: Un gros NAS.

Bon, clairement le circuit Asmedia ASM 1064/116X cause beaucoup de soucis, il équipe pas mal de cartes en tant que contrôleur SATA

il est compliqué de récupérer la dernière version de Firmware, je tente (pas longtemps)

https://www.techpowerup.com/forums/thre ... st-5190114

il est compliqué de récupérer la dernière version de Firmware, je tente (pas longtemps)

https://www.techpowerup.com/forums/thre ... st-5190114

Re: Un gros NAS.

Ah un truc qui arrive avec les pcie1.

Le port prend la poussière !

Même si la je ne pense pas que ce soit le cas.

Bios/uefi a jour ?

Pour le flash, je confirme que dessouder et le mieux à faire !

Le port prend la poussière !

Même si la je ne pense pas que ce soit le cas.

Bios/uefi a jour ?

Pour le flash, je confirme que dessouder et le mieux à faire !

Re: Un gros NAS.

oui tout est propre et à jour

non mais en fait le chipset est visiblement moisi, en cherchant "Asmedia ASM 1064/116X firmware" on trouve pas mal de matos à base de ça et ça merdoie, même si la plupart on seulement un souci d'incompatibilité avec Intel 600.

J'ai récupéré 3 firmwares, demain je teste ça, là j'en ai marre, j'ai collé des HDD :/ dans le NAS, j'ai peuplé pool/datasets et je scp depuis le NAS2 ... demain ça devrait être bon et je saurai si les disques sont ok.

non mais en fait le chipset est visiblement moisi, en cherchant "Asmedia ASM 1064/116X firmware" on trouve pas mal de matos à base de ça et ça merdoie, même si la plupart on seulement un souci d'incompatibilité avec Intel 600.

J'ai récupéré 3 firmwares, demain je teste ça, là j'en ai marre, j'ai collé des HDD :/ dans le NAS, j'ai peuplé pool/datasets et je scp depuis le NAS2 ... demain ça devrait être bon et je saurai si les disques sont ok.

Re: Un gros NAS.

bon ben 2 cartes brickées

---

Dernier test sur la carte restante.

4 disques M2 accessibles OK.

Test de débit (utilitaire "disques" Ubuntu) 500+ Mo/s lecture écriture sur 1 disque.

remplissage de 0 ou de random sur 1 disque, débit ~340 Mo/s

remplissage de 0 ou de random sur 2 disques simultanément, débit ~115 Mo/s chacun

si on tente une opération sur un 3è disque, cela s’effondre à 8 Mo/s

un 4è disque ... on est dans les Ko/s

On ne peut pas utiliser les 4 disques en les groupant en soft (agrégat Windows ou ZFS Linux), si on reste en 4 disques séparés il faut n'en utiliser qu'un ou 2 à la fois.

Il y a clairement un souci.

---

Dernier test sur la carte restante.

4 disques M2 accessibles OK.

Test de débit (utilitaire "disques" Ubuntu) 500+ Mo/s lecture écriture sur 1 disque.

remplissage de 0 ou de random sur 1 disque, débit ~340 Mo/s

remplissage de 0 ou de random sur 2 disques simultanément, débit ~115 Mo/s chacun

si on tente une opération sur un 3è disque, cela s’effondre à 8 Mo/s

un 4è disque ... on est dans les Ko/s

On ne peut pas utiliser les 4 disques en les groupant en soft (agrégat Windows ou ZFS Linux), si on reste en 4 disques séparés il faut n'en utiliser qu'un ou 2 à la fois.

Il y a clairement un souci.

Re: Un gros NAS.

Bon, et bien finalement, devant tous ces écueils matériels, je me replie sur une version disques mécaniques

Donc emploi de SSD pour SLOG et L2ARC.

---

Bon, ben ça reste potable, en tout cas supérieur au débit réseau.

Donc emploi de SSD pour SLOG et L2ARC.

---

Bon, ben ça reste potable, en tout cas supérieur au débit réseau.

Re: Un gros NAS.

Faut que je test SnapRAID en debit de mon côté, au moins pour de la sauvegarde ça semble assez pertinent.

Re: Un gros NAS.

J'ai lu quelques articles dessus, de mon point de vue il apparait moins souple que ZFS.

Re: Un gros NAS.

Mais moins couteux ?

Doute sur la capacité d'extension des grappes, mais je comprens que ca reviens a faire une full synchro= le disque de snap en full . Ce qui reste raisonnable vs un rebuild complet d'une grappe z2 de 30 hdd...

Doute sur la capacité d'extension des grappes, mais je comprens que ca reviens a faire une full synchro= le disque de snap en full . Ce qui reste raisonnable vs un rebuild complet d'une grappe z2 de 30 hdd...

Re: Un gros NAS.

C'est pour ça que pour ZFS il faut éviter les grosses grappes Z2 car en cas de rebuild ça met un gros stress sur les autres disques.

J'ai lu pas mal d'articles qui préconisent les mirrors, d'où mon test (captures d'écrans au dessus).

J'ai lu pas mal d'articles qui préconisent les mirrors, d'où mon test (captures d'écrans au dessus).

Re: Un gros NAS.

Tu es a combien de taux d'espace utile pour quelle capacité de perte ?