Bon ici je parle matos HDG, comparaisons d'architectures ... dans le but d'avoir du matos au max de performance, a prix raisonnable ou déraisonnable mais justifié

Donc les besoins/applications de ce genre de matos, je m'en contrefou dans ce topic.

Ca fait un petit moment que j'avais pas sorti de gros topic, mais là je tiens une perle donc :

Suite a une petite occasion qui c'est présenter (no comment), j'ai pu récupérè pour 470€ un SSD intel 910 version 800GB. [:v10ware:2]

Je n'aurai jamais claqué plus pour du SSD pcie de ce type, connaissant déjà les défauts (volontaire ?) de conception sur ce genre de matos j'ai quand même fait cette achat pour confirmer mes Hypothèses certitude sur les SSD pcie.

Et accessoirement justifier mes dires par moult test et screen persso.

Anandatech a fait une bonne présentation du produit donc je me fais pas chier a la refaire: http://www.anandtech.com/show/6124/the- ... 910-review

-Déjà le bouzin ne possède pas de bios ;(

Seul un utilitaire a géré en CMD (isDTC

-De base on ce retrouve donc avec 4 volume indépendant de 200GB.

Et puis voila, bah c'est tout.

Pas de possibilité de raid HW, pas de coprocesseur puissant, intégré sur le matos pour calcul dédier.

A aucun moment dans la doc technique du matos il n'est dit que le raid était possible.

Mais quand même, je partais du principe qu'un truc a 4K€ le gérer forcement; la performance etant le but de ce genre de produit, le raid est obligatoire de apr ca conception.

Bon nombre de SSD PCIE meme moyen de gamme ont un raid''0'' imposer sur les 2 a X module SSD indépendant. ex les revodrive.

Seul dans la FAQ intel il et dit:

Superbe nan ?''Produits Intel® Solid-State lecteur 910 série (Intel® SSD 910 série) sont conçus avec plusieurs disques/contrôleurs de 200 Go pour maintenir les performances. Le modèle de 400 Go a deux lecteurs et le modèle de 800 Go a quatre disques. Chaque contrôleur est considérée comme un lecteur individuel par le système d'exploitation. Vous pouvez utiliser vos utilitaires de gestion de disque du système d'exploitation ou un utilitaire RAID logiciel pour agréger les disques en fonction des besoins. Le RAID matériel n'est pas prise en charge de la série Intel® SSD 910.''

Donc on ce retrouve tout simplement avec un pauvre contrôleur raid pas raid

*Flou total sur la gestion du TRIM et pas de gestion d’encryptage.

2GB de ship ram sont quand même souder sur l'étron histoire d'avoir un peu de buffer et cheater dans les bench.

En 8X 2.0 comme tout bon contrôleur raid qui se respecte.

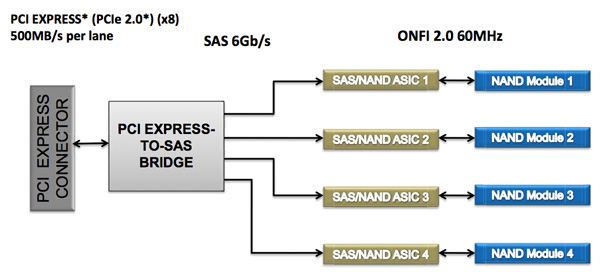

Coter HW chip on a un switch sas/sata to PCIE LSI: LSI SAS 2008

En gros c'est un chipe all on one qui fait switch pcie/sas/sata mais possède aussi des unité de calcul pour les fonction raid HW. car oui ce chip seul gère le raid HW (il intègre un PPC monocore a 533MHz).

Comme le précise bien anandthech, ce chip et tres largement utiliser sur pas mal de SSD pcie avec parfois/souvent les fonctions raid activé.

Pour preuve mon SSD et détecter en tant que:

Génération antérieur au 910 intel.

Tite digressions:

- Les meilleur contrôleur comme arecapossède généralement un chip CPU PPC puissant ( dualcore a 1.2GHz depuis la serie 18xxx) avec interface ram, et 4/8 sortie sas/sata; vers 2 a 3 chip switch de multiplexage sas/sata.

- Sur les SSD pcie fusion IO et maintenant d'autre modèles, l'adressage se fait totalement différaient.

Pour faire simple fusion IO utilise un chip proprio d'adressage direct vers chacun des chip SSD (pas module mais bien chip) ce qui fait un nombre de bitbites E/S énorme.

la bande passante max reste aux alentours des 1.5 2GB réel par contrôleur (surement un plafonnement du au perf de calcul des chip dédier) mais les IOPS sont énorme du fait de la très faible latence (car accès direct de toutes les cellules apr le ship de contrôle général) donc monter en débit très rapide de ce genre de système + utilisation de type de cellule a cycle très court.

Mais ils font payer ce genre de solution clairement trop cher/capacité.

A cause du firmware intel, les fonctions raid HW du chip sont donc bridées. Mais WHY ???

Bande passante et IOPS trop violent pour le petitPPC ? Coute trop cher de foutre un PPC dédier en + ? ....

En chip SSD on a 4:

Utiliser sur les SSD sata classique hitachi SSD400M (trouvable a 330€ les 450GB).

Pas envie de rentré dans les détails spécifique de ces contrôleur, car peu d'incidence réel sur les perf de SSD en raid.

Quelque info sympa en +, toujours sur anandtech.

Coter bootabilité, bah vu que seul un raid soft logique et faisable, bah dur de booter dessus même si cela reste possible, même pour win.

La flemme de rentré dans le détail mais la manip s'apparente au boot on ram de XP: http://diddy.boot-land.net/firadisk/fil ... ll_ram.htm

Néanmoins, les perf.

La on entre dans un domaine complexe.

Bench un SSD n'est pas simple pour plusieurs raison:

-Le buffer

-les différents algo (souvent proprio) de compression

-les data très compressible de la plupart des bench

-la mise en raid de module SSD indépendant complique encore plus tout ca

-la variété des différentes archie des SSD PCIE

-la variété des différents contrôleur et type de cellule.

-Un SSD encore plus en PCIE, n'a pas une monter en débit linéaire.

Bref tout ça complique grandement les bench de ce genre de matos car les comportements sur un même bench peuvent être très divers.

Pour saisir la complexité du truc et les arnaques des spécifications constructeur, 2 ti article de référence:

http://www.hardware.fr/articles/860-4/s ... ntion.html

http://www.hardware.fr/articles/860-5/i ... ntion.html

Encore GG pour le taf de MARC. [:bejita ssj4:3]

Je posterai plus tard MES bench persso a coup d'IOmeter bien paramétré + des soft classique avec explication des différant ''moment de débit''.

+ Si vous êtes sages et gentils des test comparo VS mes system ram ...

Bon suite a un élan de motivation:

Le SSD étant donc détecter en 4x 200GB je suis obliger de crée un raid0 logique sous win.

*A ma connaissance les quelque soft de création de raid logique sous win, étant de simple gui modifier reprenant l'utilitaire windows d'agrégation de bandes (avec dé fois quelque option en plus) , Je passe donc directement par le gestionnaire de disk win.

Donc pour commencer les bench:

Qé qu'ont voie ?

Donc la, le test est: une simple suite de fichier de 16 MB écris puis lut, les un a la suite des autre.

Donc en fonction des écritures, la position (adressage secteur) progresse vers la fin.

Ce bench permet de mettre en évidence des potentiel différent moment de monté en débit; et la, il y en a plein.

Difficile d'extrapoler le fonctionnement du SSD avec tous ces moment différant.

Ce qui me choque le plus étant que le SSD n'arrive pas a sont débit max apré l'utilisation du cach. Un set de position de demarage genre a 20% ne change rien.

Il semble lui falloir un certain quota d'écriture avant d'activer les 4 module SSD et atteindre ca saturation de débit.

Une réitération du bench fait disparaitre la 1ere courbe sinusoïdale de monter en débit, pour directement commencer a environ 1GO/s

Le volume étant un raid logiciel, donc avec data de config raid écrite directement sur le volume, un bench en écriture supprime ces data et casse le raid logique.

Même en commençant sur une position avancer sur le volume ;(

Pour HDtune et d'autre bench du même genre, il n'arrive pas à check le volume logique, et ne voie donc que les volumes physiques:

Même si ca n'a pas une grande valeur (puisque difficile de connaitre l'influence des différant moment de débit sur le résultat final), je poste un screen sous ATTO et crystal disk marck:

Taille des data en 5GB

Taille des data en 50MB

Les perf en 4K sont quand même remarquablement faibles, malgré l'influence des 2GB de buffer.

En QD2:

http://img4.hostingpics.net/pics/221102 ... 132918.png

En QD 10:

http://img4.hostingpics.net/pics/389768 ... 133537.png

conclusion:

POUBELLE l'intel 910 800GB !!!

Ti HS:

Dans tous les cas le system idéal actuel SSD reste:

Conf bi 2011 avec 2 areca 1882 par CPU (1 areca sature a 1.3GB/s réel) donc 3 SSD (qui rox en IOPS) en raid0/areca suffise sinon + de SSD augmentent la latence générale donc baisse d'IOPS.

+ raid0 soft des 4 volume raid0 HW.

= poutrage de

Ce qui nous donne approximativement un débit max de 4.3GB/s réel

IOPS dur à calculer réellement pour la raison dite plus haut, plus le fait d'avoir 16GB de buffer.

Mais dans l’absolue, le débit max + le gros buffer étant énorme, cela compense la latence du a la complexité du system + raid HW + raid soft.

Selon moi 2 areca ne saturent pas la BP max pcie sur 1 CPU (sauf moment d'E/S sur le cach de 4GB).

Donc upgrade possible avec 6 areca

Pour le safe des data tu fais un mirror vers un 5eme areca indépendant, dédier backup ...

Bref mag des bench de l’intel 910 + explication, bientôt